AI: Servidores

Acerca de

Agent DVR se integra completamente con servidores de IA como DeepStack AI, CodeProject AI, PlateRecognizer.com, Claude, Gemini, OpenAI (ChatGPT) y LLMs locales como Ollama, vLLM y LM Studio para añadir filtrado inteligente de alertas, reconocimiento de objetos, reconocimiento de escenas y control inteligente de eventos.

Además de DeepStack y CodeProject AI, también puedes usar otros servidores de IA que soporten la misma API:

Reconocimiento de Objetos y Visión por Computadora

- https://codeproject.github.io/ - Servidor de Procesamiento de IA basado en GPU/CPU multiplataforma

- https://docs.platerecognizer.com/ - Servidor de Reconocimiento de Matrículas (API basada en la web)

- https://github.com/runningman84/docker-coral-rest-server - Modelos Tensorflow-lite en un RPi (o Linux/Mac) con aceleración de un stick USB Coral

- https://github.com/robmarkcole/coral-pi-rest-server/ - Modelos Tensorflow-lite en un acelerador USB Coral a través de una aplicación Flask

- https://github.com/xnorpx/blue-candle - Servidor de reconocimiento de objetos super pequeño

Servicios de IA en la Nube

- https://platform.openai.com/ - API de OpenAI (ChatGPT, GPT-4 Vision) para análisis de imágenes y chat

- https://console.anthropic.com/ - API de Anthropic Claude para razonamiento avanzado y comprensión de imágenes

- https://ai.google.dev/ - API de Google Gemini para capacidades de IA multimodal

- https://docs.anthropic.com/ - Documentación de la API de Claude

- https://platform.openai.com/docs/ - Documentación de la API de OpenAI

- https://ai.google.dev/gemini-api/docs - Documentación de la API de Gemini

Servidores de IA Locales (LLMs)

- https://ollama.com/ - Ollama: Ejecuta modelos de lenguaje grande localmente

- https://docs.vllm.ai/ - vLLM: Inferencia y servicio de LLM de alto rendimiento

- https://lmstudio.ai/ - LM Studio: Aplicación de escritorio fácil de usar para LLMs locales

- https://github.com/ollama/ollama - Repositorio de GitHub de Ollama

- https://github.com/vllm-project/vllm - Repositorio de GitHub de vLLM

Configurando IA

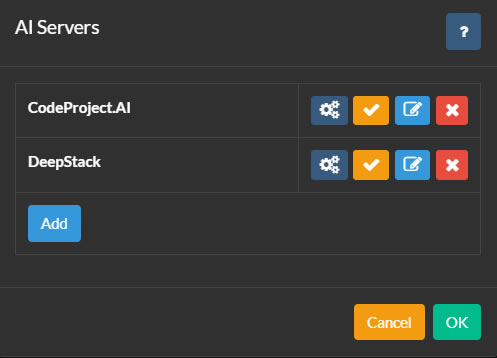

Para configurar Servidores de IA, haga clic en el icono en la parte superior izquierda de la interfaz principal de Agent DVR. Luego haga clic en Configuración bajo Configuración, seleccione Servidores de IA en el menú desplegable y haga clic en Configurar.

Agent DVR se integra con CodeProject.AI para diversas funciones de IA, incluido reconocimiento de objetos, reconocimiento facial, ALPR (Reconocimiento Automático de Matrículas) y super resolución (mejora). PlateRecognizer.com también es compatible como proveedor de ALPR. CodeProject.AI es de código abierto, gratuito y compatible con la mayoría de las plataformas.

Para comenzar, instale un servidor de IA para su plataforma y conéctelo a Agent DVR haciendo clic en el botón Configurar y luego en Añadir.

Puede agregar tantos servidores de IA a Agent como sea necesario. Las cámaras en Agent se pueden configurar para usar diferentes servidores de IA para cada función, o puede usar un servidor de IA para todas las tareas.

Configurando su Servidor

- Nombre: Nombre de su servidor, por ejemplo, Atrapador de Gatos.

- URL del Servidor de IA: Ingrese la URL de su servidor de IA, por ejemplo, http://localhost:32168/

- Clave API: Ingrese su clave si está configurada (opcional).

- Tiempo de espera: El tiempo en segundos para las solicitudes al servidor.

- Retraso de reintento: El tiempo en segundos antes de volver a intentar una solicitud fallida a este servidor.

Haga clic en OK para guardar su configuración.

Utilizando OpenAI

Para configurar OpenAI ("Chat GPT") para responder preguntas sobre lo que está sucediendo en su transmisión de video, vaya a Configuración del Servidor - Servidores de IA y seleccione "Open AI" en Preguntar a la IA.

- URL: Ingrese la URL del servicio. El valor predeterminado es "https://api.openai.com/v1/chat/completions".

- Clave de API de OpenAI: Después de registrarse en OpenAI, vaya a la Página de Claves API y genere una nueva clave secreta. Copie y pegue esta clave en el campo especificado.

- Modelo: Especifique el modelo a utilizar. El valor predeterminado es gpt-4o. OpenAI puede eliminar o cambiar esto en un momento posterior.

- Máximo de Tokens: Esto establece el uso máximo de tokens por solicitud. Si encuentra problemas, verifique los registros en /logs.html, ya que podría estar relacionado con el uso de tokens.

Una vez configurado OpenAI, consulte Preguntar a la IA para obtener instrucciones sobre cómo utilizarlo para responder preguntas generales sobre lo que está sucediendo en la transmisión de su cámara.

Usando Claude

Para configurar Claude AI para responder preguntas sobre lo que está sucediendo en su transmisión de video, vaya a Configuración del Servidor - Servidores de IA y seleccione "Claude" en Preguntar a la IA.

- URL: Ingrese la URL del servicio. El valor predeterminado es "https://api.anthropic.com/v1/messages".

- Clave de API de Claude: Después de registrarse en Claude, visite la Página de Claves de API y cree una nueva clave secreta. Copie y pegue esta clave en el campo.

- Versión: Especifique la versión a utilizar. El valor predeterminado es 2023-06-01. Esto puede ser eliminado o cambiado en algún momento por Anthropic.

- Modelo: Especifique el modelo a utilizar. El valor predeterminado en el momento de la escritura es claude-3-sonnet-20240229.

- Máximo de Tokens: Esto controla el gasto máximo de tokens por solicitud. Revise los registros en /logs.html si tiene problemas, ya que podría estar relacionado con el gasto de tokens.

Una vez que Claude esté configurado, consulte Preguntar a la IA para ver cómo usarlo para reconocer escenarios generales en la transmisión de su cámara.

Usando Gemini

Para configurar Gemini para responder preguntas sobre lo que está sucediendo en su transmisión de video, vaya a Configuración del servidor - Servidores de IA y seleccione "Gemini" en Preguntar a la IA.

- URL: Ingrese la URL del servicio. El valor predeterminado es "https://generativelanguage.googleapis.com".

- Clave de API de Gemini: Después de registrarse en Gemini, visite la Página de claves API y cree una nueva clave secreta. Copie y pegue esta clave en el campo.

- Versión: Especifique la versión a utilizar. El valor predeterminado es v1beta. Esto puede ser eliminado o cambiado en algún momento por Google.

- Modelo: Especifique el modelo a utilizar. El valor predeterminado en el momento de la escritura es gemini-1.5-flash.

- Máximo de tokens: Esto controla el gasto máximo de tokens por solicitud. Revise los registros en /logs.html si tiene problemas, ya que podría estar relacionado con el gasto de tokens.

Una vez que Gemini esté configurado, consulte Preguntar a la IA para saber cómo usarlo para reconocer escenarios generales en la transmisión de su cámara.

Usando otros servidores LLM

Desde v6.5.3.0+ puedes usar tus propios servidores LLM locales (como vLLM, Ollama y LM Studio) para describir las imágenes que Agent DVR captura de tus cámaras en eventos de alerta y responder preguntas sobre lo que está sucediendo en tus transmisiones de video. Consulta AI Describe y Ask AI.

Para configurar un servidor de IA local, ve a Configuración del Servidor - Servidores de IA y haz clic en el botón Configurar junto al LLM que deseas usar (Ollama, vLLM o LM Studio).

- URL: Especifica el punto final donde se está ejecutando tu servidor LLM. Las URLs predeterminadas son:

- Ollama:

http://localhost:11434/api/chat - vLLM:

http://localhost:8000/v1/chat/completions - LM Studio:

http://localhost:1234/v1/chat/completions

- Ollama:

- API Key: Si tu servidor LLM requiere autenticación, ingresa la clave API aquí. La mayoría de los servidores locales no requieren esto a menos que se configuren específicamente.

- Modelo: Selecciona el modelo capaz de visión para usar en el análisis de imágenes. Debes haber descargado y cargado este modelo en tu servidor LLM. Las opciones populares incluyen:

- Modelos LLaVA (visión de propósito general)

- Qwen2-VL (alto rendimiento)

- Llama 3.2 Vision (el más reciente de Meta)

- Temperatura: Controla la creatividad frente a la precisión en las respuestas (0.0-1.0). Valores más bajos (0.3-0.4) producen descripciones más fácticas y consistentes. Valores más altos (0.6-0.8) generan respuestas más variadas y creativas. Recomendado: 0.4 para el análisis de cámaras de seguridad.

- Max Tokens: Número máximo de palabras/tokens en la respuesta de la IA. Valores más altos permiten descripciones más detalladas pero tardan más en generarse. Recomendado: 300-500 para análisis de imágenes detallados, 150-250 para descripciones breves.

- top_p: Controla la diversidad de la respuesta limitando la selección de vocabulario (0.0-1.0). Valores más bajos utilizan palabras más comunes, valores más altos permiten un vocabulario más variado. Recomendado: 0.9 para un buen equilibrio entre precisión y lenguaje natural.

- top_k: Limita al modelo a elegir entre las K palabras siguientes más probables. Valores más bajos (20-40) producen respuestas más enfocadas, valores más altos (80-100) permiten más variedad. Recomendado: 50 para descripciones de imágenes confiables.

Utilizando PlateRecognizer.com

- URL: Ingrese la URL del servicio. La predeterminada es "https://api.platerecognizer.com/v1/plate-reader/", o use su propio servidor si aloja su propia instancia.

- Token: Después de registrarse en Plate Recognizer, visite la Página de Cuenta y copie el Token de API.

- Regiones: Deje en blanco para usar la predeterminada o ingrese una lista CSV de regiones.

- Config: Ingrese valores de configuración adicionales de la documentación si es necesario.

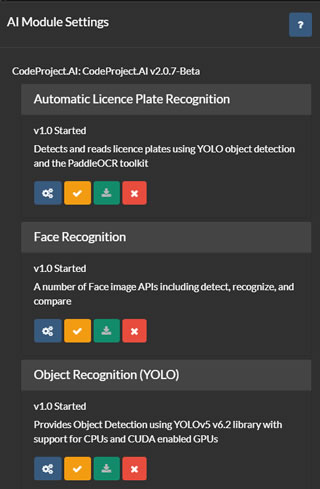

Gestionando módulos de IA

En la lista de servidores de IA (referenciada arriba), tienes opciones para configurar, probar, editar y eliminar servidores de IA. Haz clic en el botón de configuración para mostrar los módulos disponibles o instalados en el servidor seleccionado.

Agent DVR obtiene la lista de módulos actual del servidor y ofrece una interfaz de usuario para instalar, desinstalar, configurar y probar cada módulo. Se brinda soporte para todos los módulos predeterminados de CodeProject.UI, aunque Agent DVR solo utiliza un subconjunto de estos.

Para utilizar ALPR (Reconocimiento Automático de Placas de Matrícula), Super Resolución o Reconocimiento Facial en Agent DVR, deberás instalar el módulo respectivo desde esta página. Por lo general, la configuración predeterminada es suficiente para estos módulos, pero puedes configurarlos haciendo clic en el icono de debajo de cada módulo.